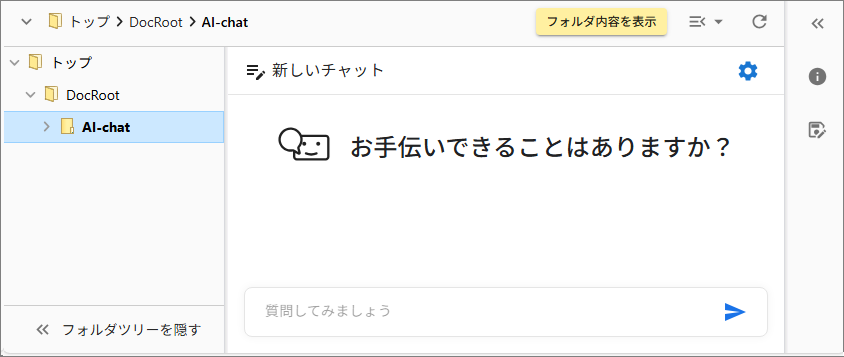

チャット設定

FileBlogトーク用のシステム設定(http(s)://xxx/filetalk)で各種設定を行います。

実際に利用するチャットの仕様(LLMモデルや各種動作)を定義します。

設置する各チャット(チャット画面)に応じた仕様を定義できるようになっています。

[1]最小構成の設定例

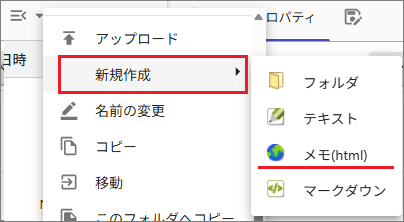

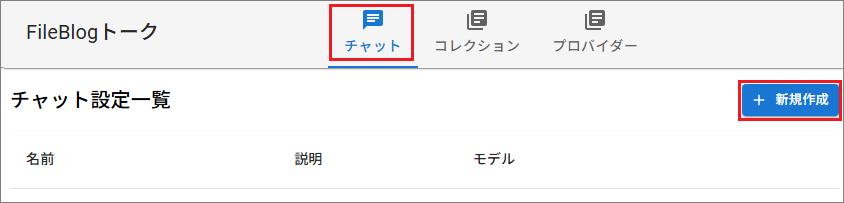

システム設定で[チャット]を選択します。

画面右上の[新規作成]を選択します。

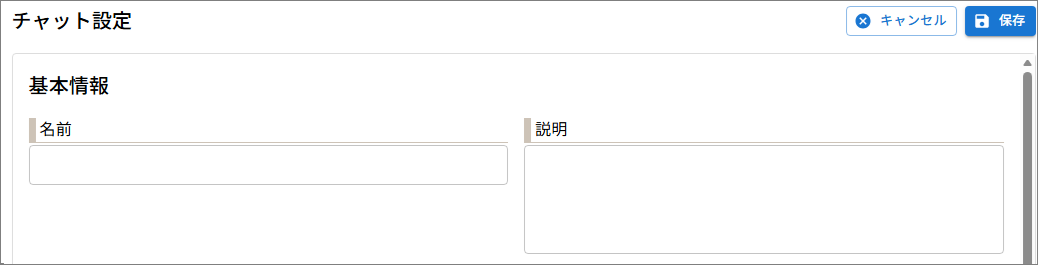

[基本設定 > 名前]に、チャット定義の任の名称を入力します。

必要に応じて[説明]にコメントを入力します。

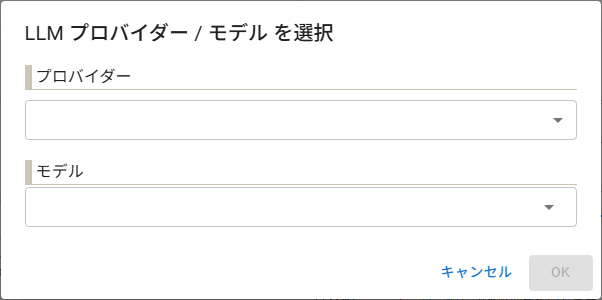

[LLM > モデル > 変更]を選択して、連携するプロバイダーとLLMモデルを選択します。

[プロバイダー]:表示される設定済みのプロバイダーの一覧から選択します。

[モデル]:表示されるプロバイダー対応のモデル一覧から選択します。

必要に応じてほか項目を設定します。

[保存]で設定を保存します。

モデル一覧

LLMのモデル一覧は

models.jsonに定義されている内容を表示します。models.jsonを修正することでモデルの追加や削除ができます。モデル選択のダイアログにモデル名を直接入力して指定することもできます。(対応していないモデル名を入力するとチャット実行時にエラーになります)

チャット設定項目

基本情報 |

説 明 |

|---|---|

名前(必須) |

チャット設定の識別子です。全半角文字が使用できます。 |

説明 |

チャット設定の説明情報を登録できます。 |

LLM設定(必須設定) |

説 明 |

|---|---|

モデル |

プロバイダーとLLMを指定します。 |

最大思考ステップ数 |

LLMが推論を行うステップ数の上限を制御する設定です。値を上げると回答の丁寧さや整合性が向上するが応答時間や利用コストが増加しやすくなります。 |

最大トークン数 |

LLMが一度の応答で生成できるトークンの最大数です。値が小さいと回答が途中で切れたり要約が不十分になり、大きいと長文に対応できるが応答時間や利用コストが増加しやすくなります。 |

Tenperature |

値が0に近いほど同じ質問に対しては同じ結果になります。(確定的、事実重視) 値が2に近いほど不確かさやランダム性を考慮した結果になります。(確率的、創造的、表現多彩) |

質問設定(任意設定) |

説 明 |

|---|---|

ヒント生成元コレクション |

LLMへの問合わせ前に予め用意したヒントを指定(選択)できるようになります。 |

ヒント選択閾値 |

値が1に近づくほどヒントが表示されるようになりますが、質問とヒントとの関連性も小さくなる傾向です。 |

ヒント表示数 |

表示するヒント数です。予め用意したヒント数を超える数の表示はできません。 |

FileBlogのアクセス許可する 最上位フォルダ |

LLMに回答生成のための情報収集が許可される範囲です。 |

プロンプト末尾テンプレート |

入力した会話(質問等)を実行すると末尾に必ず付加されるプロンプト情報です。出典ファイルを表示させるプロンプトの用意があるのでサポートまでご連絡ください。 |

既定のユーザーの質問文 |

新しい会話を始めると必ずプロンプトに入力されている内容です。 |

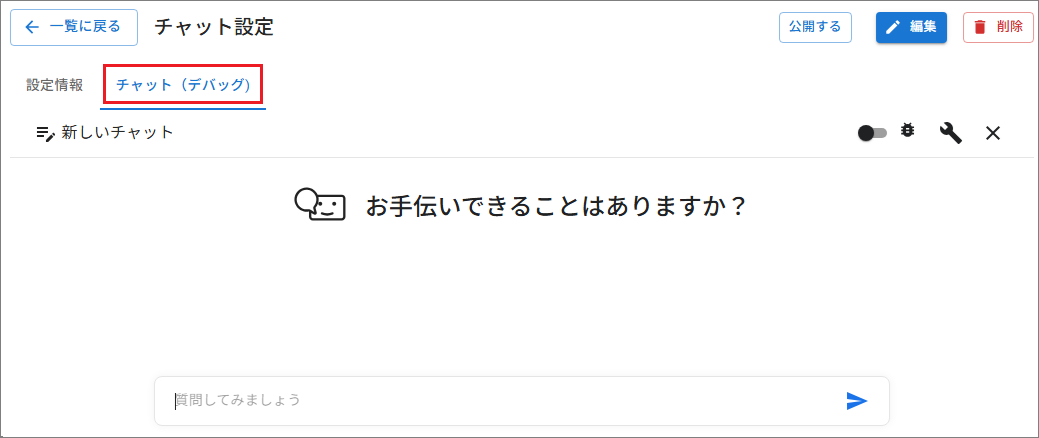

[2]設定後の動作確認

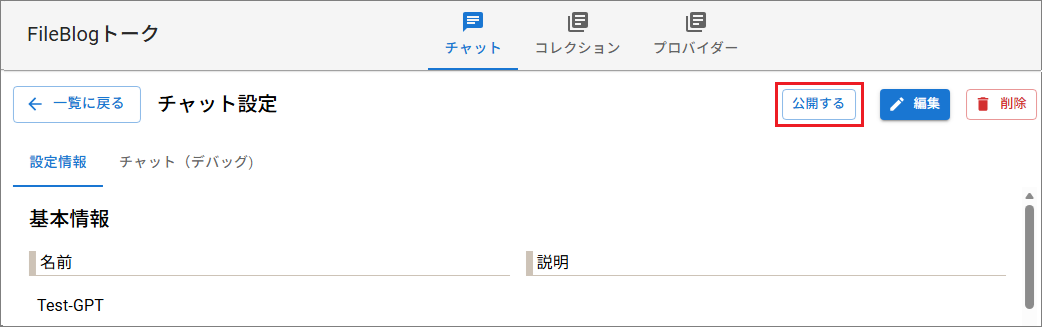

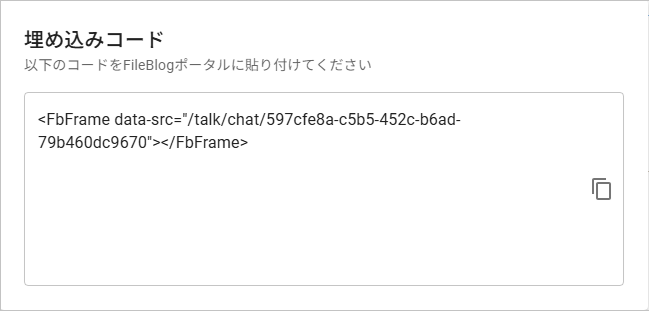

[3]チャットの公開

ポータル機能を使ってチャット用の画面を表示させます。